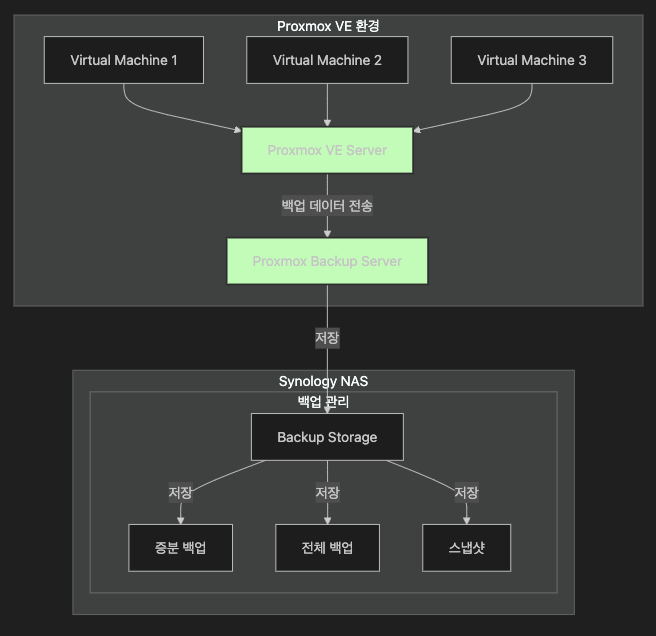

안녕하세요! 이번 블로그에서는 Proxmox Backup Server(PBS)를 Synology Virtual Machine Manager(VMM) 환경에 설치하고, 효율적인 백업 시스템을 구성하는 과정을 소개하려고 합니다. Proxmox Backup Server는 고성능의 백업 솔루션으로, Proxmox VE 환경과 완벽하게 통합되어 안정적이고 효율적인 백업 및 복구 기능을 제공합니다. 특히, 데이터 중복 제거(Deduplication), 압축, 암호화와 같은 고급 기능을 제공하여 IT 환경의 백업 관리를 한층 더 간편하게 만들어줍니다. 왜 Synology VMM과 PBS를 함께 사용할까요?Synology NAS는 뛰어난 스토리지 솔루션을 제공하며, VMM(Virtual Machine Manager)을..